Si hay algo que aprendí durante los 15 años que trabajé en la Búsqueda de Google, es que la curiosidad de las personas es infinita. Recibimos miles de millones de búsquedas todos los días y el 15 por ciento de esas consultas son nuevas, nunca se habían hecho antes. Por eso hemos creado formas de entregar resultados para consultas que no podemos anticipar.

Cuando personas como tú o como yo acudimos a Google, no siempre estamos seguros de cuál es la mejor manera de formular una consulta. Es posible que no sepamos usar las palabras correctas o cómo deletrear algo. Muchas veces acudimos a la Búsqueda con la intención de aprender y no necesariamente tenemos ese conocimiento inicial.

En esencia, la Búsqueda se trata de comprender el lenguaje. Nuestro trabajo es descubrir lo que estás buscando y mostrarte información útil en la web, sin importar cómo deletrees o combines las palabras en tu consulta. Si bien hemos seguido mejorando nuestras capacidades de comprensión del idioma a lo largo de los años, hay ocasiones en las que todavía no lo hacemos del todo bien, especialmente con consultas complejas o con lenguaje cotidiano. De hecho, esa es una de las razones por las cuales las personas a menudo usan alguna especie de «palabras clave» para escribir cadenas de palabras que creen que entenderemos, pero que en realidad no se parecen a una pregunta que harían de forma natural.

Con los últimos avances de nuestro equipo de investigación en la ciencia de la comprensión del lenguaje (que son posibles gracias al aprendizaje automático) estamos haciendo una mejora significativa en la forma en que entendemos las consultas, lo que representa el mayor avance en los últimos cinco años, y uno de los mayores avances en la historia de la Búsqueda de Google.

Aplicación de modelos BERT a la Búsqueda

El año pasado, presentamos y liberamos el código de una técnica neural basada en redes para el entrenamiento previo de procesamiento de lenguaje natural (PNL) llamada «Bidirectional Encoder Representations from Transformers» o para abreviar: BERT. Esta tecnología permite a cualquiera entrenar su propio sistema de respuesta a preguntas de última generación.

Este avance fue el resultado de la investigación de Google sobre transformadores: modelos que procesan palabras en relación con todas las otras palabras en una oración, en lugar de una por una en orden. Por lo tanto, los modelos BERT pueden considerar el contexto completo de una palabra al observar las palabras que vienen antes y después, particularmente útil para comprender la intención detrás de las consultas de búsqueda. Pero no sólo los avances en software pueden hacer esto posible: también necesitábamos nuevo hardware. Algunos de los modelos que podemos construir con BERT son tan complejos que superan los límites de lo que podemos hacer con el hardware tradicional, por lo que, por primera vez, utilizamos los TPUs en la nube más recientes para ofrecer resultados de búsqueda y obtener información más relevante rápidamente.

Descifrando tus consultas

Esos son muchos detalles técnicos, pero ¿qué significa todo esto para ti? Bueno, al aplicar modelos BERT tanto a los fragmentos destacados como al posicionamiento en la Búsqueda, podemos hacer un trabajo mucho mejor ayudándote a encontrar información útil. De hecho, cuando se trata de clasificar los resultados, BERT ayudará a la Búsqueda a comprender mejor una de cada 10 búsquedas en inglés en los EE.UU. y con el tiempo llevaremos esto a más idiomas y localidades.

Particularmente para consultas más largas y más coloquiales, o búsquedas en las que las preposiciones como «para» y «por» son muy importantes para el significado, la Búsqueda podrá comprender el contexto de las palabras en tu consulta. Con esto, puedes buscar de una manera que te resulte natural.

Para lanzar estas mejoras, hicimos muchas pruebas para asegurarnos de que los cambios realmente sean de mayor utilidad. Estos son algunos de los ejemplos que mostraron nuestro proceso de evaluación y que demuestran la capacidad de BERT para comprender la intención detrás de tu búsqueda.

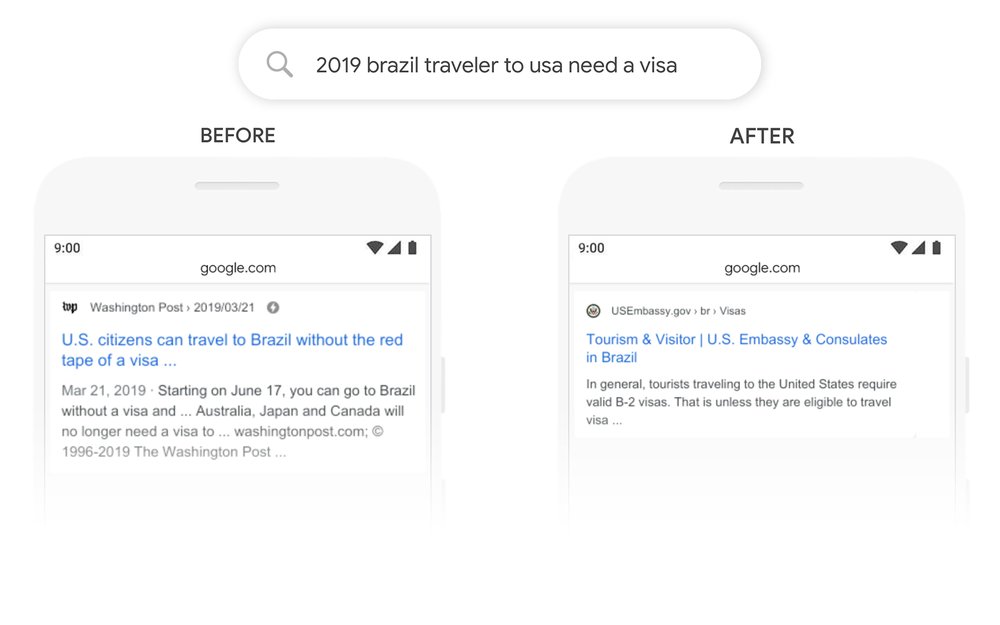

Aquí hay una búsqueda: «2019 viajero brasileño a estados unidos necesita una visa». La palabra «a» y su relación con las otras palabras en la consulta son particularmente importantes para comprender el significado. Se trata de un brasileño que viaja a los Estados Unidos, y no al revés. Anteriormente, nuestros algoritmos no entendían la importancia de esta conexión, y mostramos resultados sobre ciudadanos estadounidenses que viajan a Brasil. Con BERT, la Búsqueda puede comprender este matiz y saber que la palabra común «a» realmente importa mucho aquí, con lo que podemos proporcionar un resultado mucho más relevante para esta consulta.

Aquí hay algunos otros ejemplos en los que BERT nos ha ayudado a comprender los sutiles matices del lenguaje que las computadoras no comprenden del modo en que los humanos lo hacen. Con el modelo BERT, podemos entender mejor que «para alguien» es una parte importante de la consulta “puedes conseguir una medicina para alguien en la farmacia”, pero antes no pudimos identificar el significado y mostramos resultados generales sobre cómo surtir recetas médicas.

En el pasado, una consulta como “estacionarse en una colina sin acera” confundiría a nuestros sistemas: porque le dimos demasiada importancia a la palabra «acera» e ignoramos la palabra «sin», sin entender cuán crítica era esa palabra para responder adecuadamente a esta consulta. ¡Entonces mostramos resultados para estacionarse en una colina con acera!

Mejorando la Búsqueda en más idiomas

También estamos aplicando BERT para mejorar la Búsqueda para más personas en todo el mundo. Una característica poderosa de estos sistemas es que pueden tomar aprendizajes de un idioma y aplicarlos a otros. Por lo tanto, podemos tomar modelos que aprenden de las mejoras en inglés (idioma utilizado en la gran mayoría del contenido web) y aplicarlos a otros idiomas. Esto nos ayuda a mostrar mejores resultados en los muchos idiomas en los que se ofrece la Búsqueda de Google.

En el caso de los fragmentos destacados, estamos utilizando un modelo BERT para mejorar los fragmentos destacados en las dos docenas de países donde está disponible esta función, y estamos observando mejoras significativas en idiomas como coreano, hindi y portugués.

La Búsqueda no es un problema resuelto

No importa lo que estés buscando o el idioma que hables, esperamos que puedas dejar a un lado el lenguaje con palabras clave y buscar de una manera que te resulte natural. Pero de todas formas, de vez en cuando seguirás dejando a Google confundido. Incluso con BERT, no siempre acertamos. Si buscas «qué estado está al sur de Nebraska», la mejor predicción de BERT es una comunidad llamada «Nebraska Sur» (y si intuyes que no está en Kansas, tienes razón).

La comprensión del idioma sigue siendo un desafío constante y nos mantiene motivados para seguir mejorando la Búsqueda. Siempre estamos trabajando para mejorar y encontrar el significado y la información más útil para cada búsqueda que nos envíes.

Publicado por Pandu Nayak, Google Fellow y vicepresidente de Búsqueda de Google

Source: Google Productos